Antonio Bologna, pianista e compositore di Vigevano (PV), ha una formazione artistica e scientifica (laurea in Scienza dell’Informazione). Sono numerosi i suoi progetti come musicista e project manager. Questo il suo sito web.

Citando Igor Stravinsky, «se la musica sembra esprimere qualcosa, si tratta di un’illusione e non di una realtà. È semplicemente un elemento addizionale che le abbiamo prestato, imposto, quasi un’etichetta, un protocollo, insomma un’esteriorità e che, per abitudine e per incoscienza, abbiamo finito per confondere con la sua essenza». Cosa pensi di questa affermazione e cos’è per te la musica?

Questa frase è vera. C’era un gioco che facevo, quando ero più giovane, con un altro musicista di Vigevano che è morto un anno fa, Carlo Villa. Il gioco consisteva nel definire la musica nel minor numero di parole possibile. Lui era riuscito a trovare una definizione che impiegava quattordici parole; io ho posto fine a questo gioco e ne ho trovata una di tre: linguaggio, avvenimento e bisogno.

Linguaggio: la musica è fatta dall’uomo, passa attraverso l’uomo; i rumori e i suoni della natura sono belli e stuzzicano la mente ma non sono ancora musica. La musica esiste quando questi suoni vengono fatti propri dall’uomo. Quindi, si tratta di un linguaggio che ha alcune componenti costanti in ogni epoca, latitudine e popolo, ma dipende, per altri elementi, dalla fase storica, dalla zona geografica e, soprattutto per la musica occidentale, dalle singole personalità. Perciò possiamo ascoltare un brano musicale e riconoscere che inequivocabilmente porta la firma di quell’autore.

Avvenimento: la musica è qualcosa che accade. Quando compongo un pezzo di musica, in realtà non scrivo la musica ma scrivo un progetto di musica: scrivo qualcosa che impegnerà altre persone a far accadere un evento. Quindi, la musica prende vita nel momento in cui quel progetto sulla carta viene incarnato in qualcuno che lo esegue. Ciò giustifica il fatto che non smettiamo mai di ascoltare determinate opere musicali, anche se sono sempre le stesse, perché ogni volta che vengono riproposte sono un avvenimento nuovo. Ciò avviene sicuramente per la musica dal vivo, ma in fondo è così anche nella riproduzione meccanica: noi ascoltiamo un brano e ci accade qualcosa, che può essere ricordo, memoria o qualcosa di nuovo ogni volta.

Bisogno: è la componente che a me sta più cara. L’uomo ha bisogno di musica, altrimenti non si spiegherebbe il motivo per cui le prime esperienze del bambino sono esperienze musicali prima ancora che esperienze di parola: il bambino prima impara a cantare, poi impara a parlare. Il primo gemito, il primo urlo che fa quando nasce, è un canto.

Tornando all’affermazione di Stravinskji, per me è ovvio che la musica abbia un significato. Tuttavia, il suo significato non è qualcosa di esprimibile, codificabile o traducibile direttamente attraverso altri linguaggi perché, per esperienza, ci sono delle cose che possono essere espresse solo attraverso la musica. Il bello della musica, della poesia, della pittura e di qualunque forma espressiva umana è che solo attraverso l’utilizzo di quel linguaggio e di quella forma è possibile comunicare in modo compiuto determinate sensazioni o messaggi. Qualunque forma di traduzione, alla fine, diventa un qualcosa di artefatto e a questo si riferisce Stravinskji. L’espressione della musica, di cui parla Stravinskji, è qualcosa che noi cerchiamo di codificare e di aggiungere ad essa ma che può cambiare o essere equivocato.

Premesso che la musica sia un discorso interpretabile e relativo, riflettiamo sulla musica “a programma”: se la musica è un linguaggio indipendente, però la musica “a programma” aveva un incipit extra musicale e, quindi, in un certo senso, traduceva qualcosa.

Sì, però nel caso della musica “a programma” la “traduzione” è il mezzo e non il fine dell’opera. Mi vengono in mente, per esempio, i “Preludes” di Claude Debussy, ognuno dei quali aveva un riferimento esterno: ecco, l’Autore non scriveva il titolo del pezzo all’inizio, ma solo alla fine e tra parentesi. Un altro elemento interessante è il ruolo del compositore. Oggi ascoltiamo un brano di Stravinskji e si capisce che è suo. Lui aveva una sua cifra inconfondibile, così come vale per tutti gli altri Autori. Ciò può diventare un limite perché il rischio è far diventare questa riconoscibilità l’elemento caratteristico del pezzo. Vorrei fare un esempio pittorico, che mi ha molto colpito. Monet comprò una tenuta fuori Parigi, a Giverny, con una piccola casa e un grande parco. Negli ultimi anni della sua vita, si trasferì lì, ormai era quasi cieco, e dipingeva. Lì successe qualcosa che cambiò l’identità dell’autore Monet. Per tutta la vita aveva firmato i suoi quadri, nell’angolo in basso a destra; gli ultimi quadri non li ha più firmati. Ciò significa che, da un lato, non era necessario, e dall’altro che non era giusto che li firmasse: egli partecipava ad un processo di creazione nel quale egli era un tramite e del quale egli non era padrone.

Alla musica vengono associati sempre significati, funzioni, emozioni che forse non le sono propri. Penso ad un libro scritto da un sociologo, Michael Bull, che ha intervistato alcune persone che usano l’iPod chiedendo che rapporto abbiano con il proprio lettore audio portatile: “Sound moves. Ipod culture and urban experience“. Mi ha colpito molto l’affermazione di un intervistato: «L’iPod rappresenta il diario o la colonna sonora della mia vita. C’è una canzone legata ad ogni circostanza della mia esistenza. Anche se dovesse succedermi di dimenticare una certa situazione, persona o luogo, una canzone ha la capacità di innescare questi ricordi in poco tempo. (…) Questo oggetto è come una ‘macchina del tempo’ ed è meglio di qualsiasi diario» (Jerome, pp 136-137) Credo, per questo motivo, che il lettore musicale portatile sia un oggetto di design molto potente, perché è un contenitore di emozioni. Cosa fa la musica alle persone, così da renderle (renderci) così intimamente legate ad essa?

Secondo me, ci sono due elementi da analizzare. Per quanto riguarda il primo, dal punto di vista sensoriale, l’udito ha una carica evocativa molto più forte di tutti gli altri sensi (forse l’olfatto ha la stessa forza). Quindi, ciò che stimola l’udito ha maggiore presa sull’uomo a livello istintivo.Il secondo aspetto è legato al fatto che la musica è vibrazione e anche l’uomo e l’universo sono vibrazioni. Anticamente si era consapevoli che il suono dell’universo fosse musica; si pensava che il musicista si limitasse a rispondere all’eco della musica del Grande Artefice, che fa muovere e vibrare la musica dell’universo.

A questo proposito, mi viene in mente il pensiero di Severino Boezio. Nel De Musica affermava che la musica è di tre tipi: la musica coelestis, ovvero quella nata dalla vibrazione delle sfere celesti in cui si muovono i pianeti, il sole e le stelle, e che noi uomini non possiamo sentire; ad ogni pianeta era associata una nota musicale (sette cieli, sette note, sette giorni della settimana: il fatto che le note siano sette deriva proprio da questo). Il secondo tipo è la musica mundana, ovvero quella del mondo, come le maree, il ritmo delle stagioni, etc. che è una musica che noi non possiamo sentire ma di cui possiamo vedere gli effetti. Infine, c’è la musica humana in cui la musica mundana si rispecchia: l’uomo non fa altro che riprendere questa vibrazione. Se l’uomo è nell’universo, che è vibrazione, anch’egli è vibrazione. Non mi stupisce che il lettore Mp3 portatile possa diventare un compagno di vita e un diario della memoria e delle emozioni di un uomo, perché va a sollecitare questa componente di vibrazione in cui egli si riconosce. Tanto è vero che , nel caso dell’Ipod, diversamente dal Walkman, c’è una caratteristica interessante, ovvero la possibilità di personalizzare la playlist: la scelta dei brani è già un indirizzo, perché non si ascolta semplicemente una musica ma quella nella cui vibrazione ci si riconosce.

Come ci insegna John Cage, siamo circondati da suoni ognuno dei quali ha la sua intrinseca bellezza e dignità. Parliamo della voce umana come strumento musicale e, in particolare, della melodia della lingua italiana.

Avanzo un’ipotesi. Secondo me, il procedimento che ha portato alla formazione della lingua italiana, rispetto alle altre lingue neo-latine, è il fatto che si sia originata in un momento (XI-XII sec.) dove il legame con la musica era ancora dato per scontato. L’italiano, attualmente, ha una struttura linguistica che è così da secoli. La voce è ciò che rende viva la lingua. Un esempio: se in inglese dico “I love you” è un’ affermazione. Se dico “do you love me?” è una domanda. E’ la costruzione della frase a determinarne il tipo (affermativa o interrogativa). In italiano, la frase “tu mi ami” è uguale sia nella forma affermativa sia in quella interrogativa. Cosa cambia? Il canto. Se l’inclinazione è verso l’alto, è una domanda; se è verso il basso, è un’affermazione. Quindi, la differenza è sonora e musicale: il confine tra parlare e cantare, per me, è labile. Una conferma sono le lingue orientali, molto legate all’intonazione.

Il progetto di architettura o di design parte da un’esigenza reale o ipotizzata, la sviluppa e la risolve coerentemente con un contesto di partenza. Qual è il punto di partenza di una composizione musicale?

Secondo me, non c’è differenza tra i due ambiti. In fondo, un’opera nasce da un bisogno che, per produrre risultati davvero interessanti, non deve essere una necessità originaria dell’artista ma deve venire dal di fuori. Questo vale per il committente d’architettura ma anche per chi commissiona un brano musicale. Io mi accorgo che, se divento il committente di me stesso, i risultati sono tautologici. Invece, se il bisogno viene dall’esterno, mi pongo in una dimensione di ascolto, che è proprio quella con cui avviene la creazione. Il parlarsi addosso è sempre deleterio; sono il dialogo e l’interazione a generare. Quindi, il committente è quello capace di innescare questo meccanismo: è come se si guardasse insieme nella stessa direzione, sulla base di un bisogno che il musicista può materializzare. Il valore dei grandi committenti del passato era il fatto che essi concepivano la creazione in maniera integrata e senza differenze: potevano commissionare una sinfonia così come un palazzo, indifferentemente. Inoltre, in alcuni casi felici, l’opera ha la firma del committente, nel senso che “lui” è presente e visibile nell’opera finale. Il tentativo della partenogenesi è un rischio forte e, di solito, ci sono due sbocchi, per chi è abituato a scrivere senza commissione: o i deliri di onnipotenza che generano opere di fatto infruibili, oppure la convinzione che il proprio mercato sia il pubblico, ossia la gente che ascolta. Anche questo è deleterio, perché assecondando il gusto della gente, essendoci inevitabilmente un livellamento del gusto verso il basso, non si creano mai dei buoni risultati.

Il rapporto tra musica e spazio architettonico: come influenza le tue composizioni? Pensi allo spazio in cui le tue opere verranno eseguite oppure no?

Nella mia vita compositiva c’è un prima e un dopo. Inizialmente, la componente spaziale non mi interessava perché la dimensione legata all’avvenimento di cui dicevamo prima, ossia la musica che diventa tale nel momento in cui viene eseguita in un hic et nunc, per me non era un elemento rilevante. Poi il mio atteggiamento è cambiato. La prima occasione, in cui mi è capitato di pensare allo spazio, è stata in un brano per coro, che ho scritto una decina di anni fa, dove ad un certo punto, verso la fine, c’è una costruzione polifonica sulla base di una nota pedale. Per fare in modo che tutta questa costruzione potesse reggersi sulla nota pedale e affinché la costruzione polifonica fosse ricca, in realtà facevo suonare la nota di base solo a due persone: la capacità di sentire la nota dipendeva dallo spazio in cui avveniva l’esecuzione, perché la nota veniva scelta in modo da farla entrare in risonanza proprio con quello lo spazio. Questa fu la prima occasione; da qui, il passo successivo fu quello di riconoscere che suono e forma sono la stessa cosa. La vibrazione di uno spazio si manifesta attraverso la vibrazione dell’aria, cioè il suono. Il suono di uno spazio, nel momento in cui l’uomo lo controlla, diventa musica. Ecco quindi che l’architettura diventa il modo con cui si modella lo spazio, facendolo vibrare, e le implicazioni musicali sono immediate.

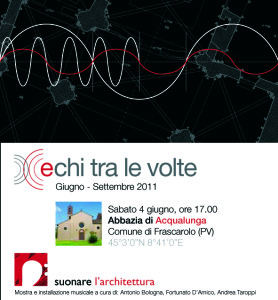

L’occasione che ho avuto, per poter sviluppare queste esperienze, è stata l’installazione “Echi tra le volte. Suonare l’architettura”. Questo lavoro ha avuto l’apporto fondamentale di Fortunato D’Amico, dal punto di vista dell’analisi architettonica, e di Andrea Taroppi, per quanto riguarda l’utilizzo della musica elettronica.

Si tratta di un’installazione di musica elettronica che va ad intercettare le frequenze di vibrazione di un determinato spazio, al fine di sfruttare questi elementi di risonanza per la stesura di una partitura musicale che, utilizzando proprio quelle frequenze di vibrazione, è la manifestazione sonora caratteristica di quel determinato spazio. Abbiamo iniziato con una verifica in una chiesa che abbiamo avuto a disposizione per circa un anno a Vigevano, provando, indagando, intuendo.

Abbiamo realizzato la prima installazione pilota, ha funzionato, ed è stato emozionante vedere che quello che noi avevamo modellato, dal punto di vista sonoro, in un altro ambiente non produceva nulla ma proprio solo in quello spazio, invece, innescava la risonanza e diventava udibile. Da lì abbiamo elaborato un format che abbiamo portato sia in Italia sia all’estero: l’ultimo allestimento risale al 2012 ed è avvenuto a Palermo, nella chiesa di San Francesco. Nel frattempo, il lavoro di ricerca è proseguito.

Per la prima installazione abbiamo impiegato un anno; per l’ultima esecuzione nella Basilica di San Francesco ci sono voluti solo due giorni di lavoro. Le prime volte infatti andavamo nei luoghi con il metro a prendere le misure, con tutte le difficoltà che ciò comporta, per calcolare di volta in volta le varie frequenze. Poi, invece, abbiamo scoperto che potevamo misurare lo spazio attraverso il suono stesso (con un procedimento simile a quello del sonar) e quindi, con un sopralluogo e pochi minuti di registrazione, potevamo stabilire quale fosse la forma dello spazio in base all’immagine sonora registrata.

Tecnicamente, “Echi tra le volte” funziona in questo modo: arriviamo in loco e in una prima fase creiamo dei suoni a picco (facilmente ottenibili con rumori banali quali il battito di mani o lo scoppio di un palloncino); di questi registriamo i tempi di riverberazione in quel preciso spazio: questo ci dà un parametro per quanto riguarda le dimensioni. Poi, da alcuni altoparlanti, emettiamo delle onde sonore che vanno a coprire l’intero spettro dell’udibile (dai 20 Hz ai 20000 Hz) e le registriamo. Dallo spettro sonoro, si vede immediatamente quali sono le frequenze che mettono in risonanza lo spazio. Dopo questa fase di sopralluogo, io scrivo una meta- partitura in cui organizzo questi suoni, suggerendo al computer le regole con cui costruire una composizione: le regole rappresentano il mio apporto creativo al lavoro e dipendono da vari fattori, tra cui anche la storia dell’edificio e il suo contesto. Dopo di ciò, installiamo il computer, lo colleghiamo ad un sistema di altoparlanti (6-8), collocati nei punti utili a questo effetto di risonanza all’interno dell’edificio. Quindi, facciamo eseguire la partitura che è costruita su frequenze che mettono in risonanza lo spazio in cui ci troviamo.

La partitura è articolata secondo tre strati: il primo (livello inferiore) è dato dalla tavolozza di note; essa varia da installazione a installazione e viene ricavata di volta in volta nel modo che ho appena descritto. Il secondo livello è la meta-composizione, ossia la struttura che viene prodotta sulla base di un algoritmo genetico, che mette in pratica le direttive che ho indicato, e produce una partitura costituita a partire dalle note dello strato inferiore. Il terzo strato, quello superiore, è quello della spazializzazione: ogni singola nota della partitura viene suddivisa in un treno di impulsi molto brevi (dell’ordine di qualche millisecondo) che, dal punto di vista percettivo non sono udibili ma, per il fatto di essere legati ad un meccanismo di risonanza, in quello spazio diventano udibili. A fianco di questa installazione, di solito presentiamo anche una mostra che raccoglie, spiega e racconta quali sono i fondamenti dell’opera e quali sono le sue basi storico-teoriche. Questa parte, come sai, è stata curata da Fortunato D’Amico, da Maurizio Splendore e da te.

Il senso ultimo di “Echi tra le volte” non ha un valore demiurgico, nel senso di organizzare e imporre esattamente tutti gli elementi di un brano musicale, dal tempo alle dinamiche, in modo che l’interprete ideale sia quello capace di entrare perfettamente in sintonia con questa perfetta organizzazione.

Però, senza arrivare agli estremi, in realtà “Echi tra le volte” non crea niente ma evidenzia qualcosa che già c’è: è questo l’aspetto che a me, in generale, interessa, ovvero il fatto che la nostra espressione non sia un atto creativo ma una invenzione, nel senso latino di invenio, che significa trovare. Secondo me, il progetto davvero efficace è quello che non pretende di imporsi ma, invece, è in grado di raccogliere ed entrare in sintonia con quello che la realtà già esprime: una rivelazione.

Per me questo è uno stimolo per ripensare alla figura del musicista. Oggi il mio lavoro è quello di progettazione, anche in ambiti diversi, non solo musicale. Mi rendo conto che ci siano forti punti di contatto anche, ad esempio, con la progettazione architettonica. Il bello è capire che non ci sono differenze e il mio obiettivo, nel mio lavoro di musicista e di operatore culturale, è proprio quello di promuovere una visione olistica e unificante dell’espressione umana.